Potencia tu tienda online con las Fichas de Productos Gratuitas de Google

Kini Calderón

Si tienes una tienda online puedes aumentar la visibilidad de tus productos en Google, captar más clientes potenciales y en definitiva vender más de manera orgánica, gracias a las «fichas de productos gratuitas«.

Esta funcionalidad es complementaria a las campañas de Google Shopping y hará que se muestren los productos de tu e-commerce en las diferentes “Superficies de Google”. Traducción de la denominación original en inglés “Surfaces across Google”.

¿Qué son las fichas de producto gratuitas?

Las fichas de productos gratuitas o listados de fichas gratuitas (free product listings) son resultados orgánicos de productos enriquecidos de una tienda online que se muestran en las diferentes plataformas de Google.

Esta funcionalidad se lanzó para Estados Unidos en enero de 2020 cubriendo en principio búsquedas relacionadas con ropa, zapatos y accesorios de moda. Poco a poco se fue extendiendo a todo el mundo y ampliando a más tipologías de productos. Puedes encontrar las políticas de Google al respecto aquí.

Las fichas orgánicas de productos ofrecen mayores oportunidades de venta a los pequeños comerciantes, aumentando su visibilidad en las SERP y pudiendo hacer frente a los grandes e-commerce y marketplaces como Amazon.

Supone un aumento de oportunidad para los e-commerce de aparecer en los resultados de búsqueda de Google de forma visual y gratuita.

Además, cabe destacar las siguientes ventajas:

- Promueven la conexión con los usuarios cuando buscan productos.

- Los resultados se muestran con datos enriquecidos, aumentando las posibilidades de que los usuarios hagan clic.

- Es una forma de diferenciarse de la competencia.

- Favorecen la llegada de tráfico orgánico a las fichas de productos de la web.

¿Dónde se muestran las fichas de producto gratuitas?

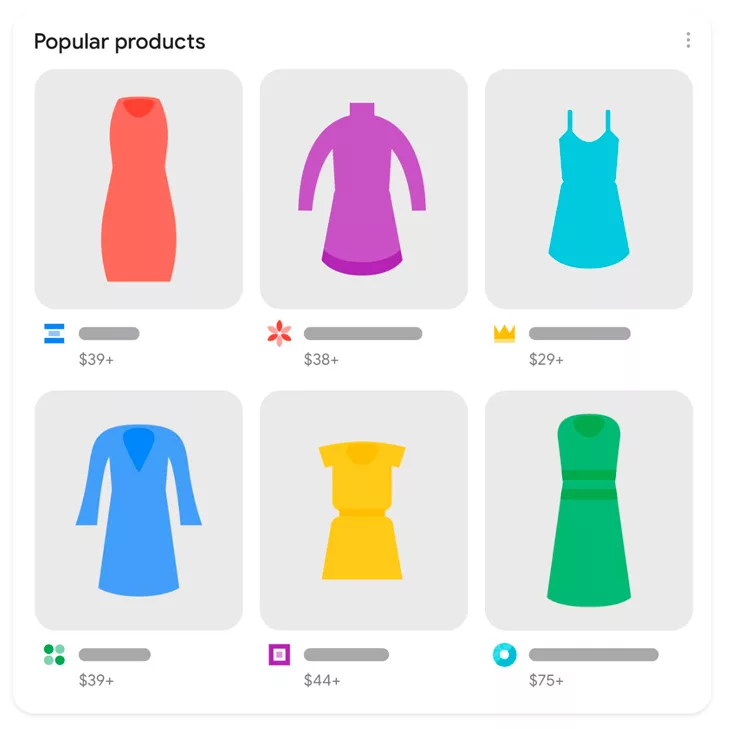

Las fichas de producto gratuitas de Google se muestran en las diferentes superficies de Google: en los resultados de búsqueda del buscador principal, en Google Imágenes, en los resultados de búsqueda de la pestaña de Google Shopping, en Google Lens y en YouTube.

A continuación, te damos más detalles de cada caso:

En los resultados de búsqueda de Google

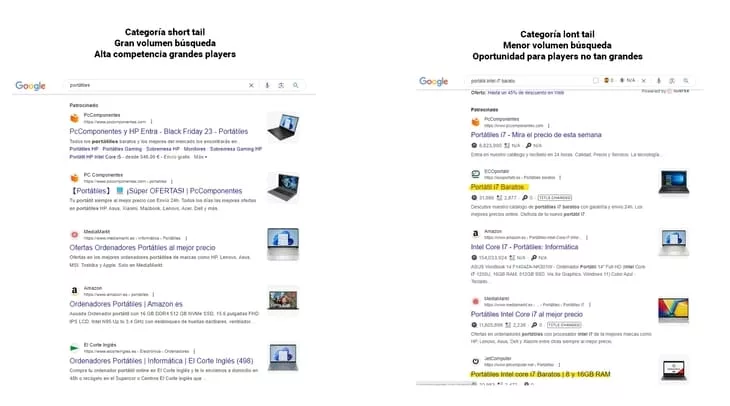

Hay varios tipos de resultados de productos enriquecidos en la búsqueda de Google:

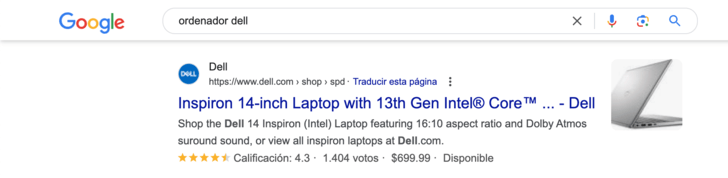

Resultados de texto con información de producto enriquecida

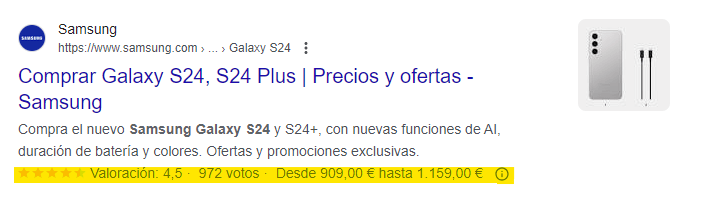

Al hacer una búsqueda en la sección principal del buscador de Google con intención de compra, junto a los resultados orgánicos de búsqueda de texto habituales, se muestran resultados más llamativos con información enriquecida que incluye una imagen, el precio, la disponibilidad y valoraciones sobre el producto.

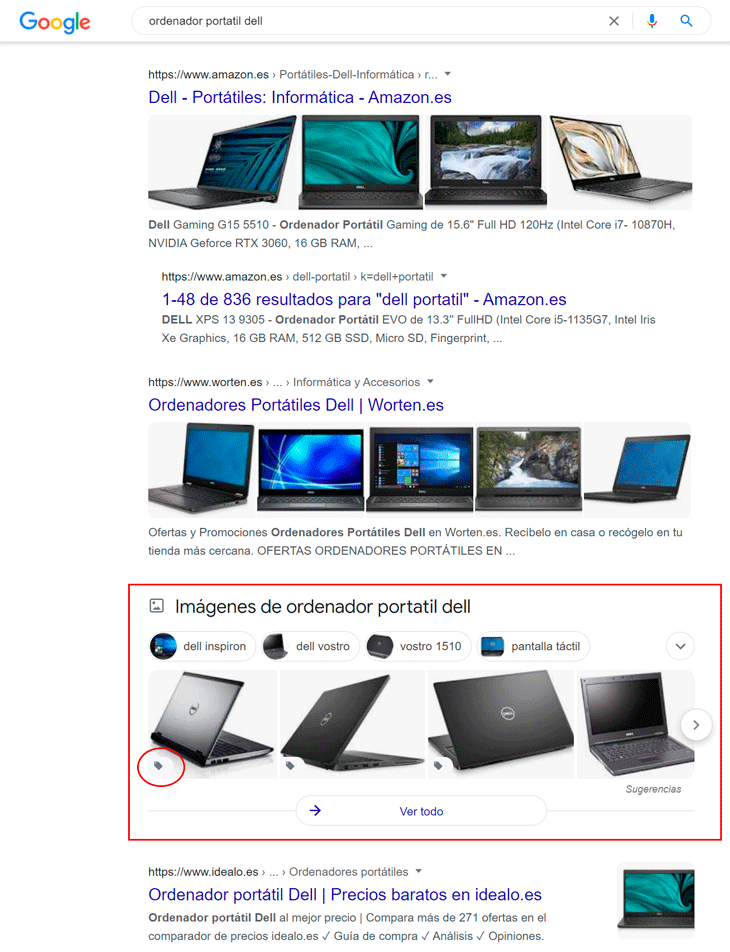

Resultados de productos en imágenes

Además de los resultados de texto enriquecidos, en la búsqueda de Google se muestran resultados de productos en imágenes. Podemos identificarlos porque muestran el icono de etiqueta de producto que se marca en la captura con un círculo rojo. Este pack de resultados es un extracto de los resultados del buscador de imágenes.

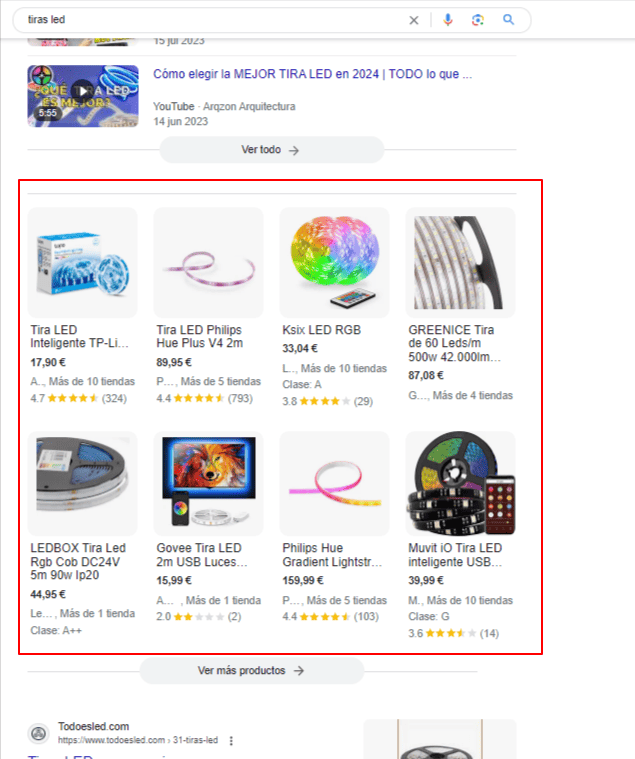

Fichas de comerciantes

Las fichas de comerciantes suponen una nueva experiencia de navegación en la búsqueda de Google. Son packs de resultados de productos similares a los resultados de Google Shopping intercalados con el resto de resultados orgánicos de la SERP. Incluyen información ampliada de los productos. Pueden aparecer varios bloques conforme descendemos en los resultados. Las fichas de comerciantes orgánicas se muestran en la siguiente captura enmarcadas en rojo.

Este tipo de resultados se lanzaron como prueba en Estados Unidos durante la primavera de 2023 y en marzo de 2024 se extendieron de forma oficial a un gran número de países, entre ellos España. Poco a poco se van mostrando en las búsquedas transaccionales de todo tipo de productos, pero la introducción en la búsqueda en España está siendo paulatina.

Además en algunos países como EEUU, al realizar búsquedas de productos transaccionales, Google está mostrando una nueva sección en la parte izquierda del buscador con una serie de filtros para afinar la búsqueda. Estos filtros ya aparecían en la búsqueda de la pestaña de Shopping y es previsible que pronto se extiendan al resto del mundo. Los filtros se muestran bajo la etiqueta «Filter by» enmarcada en naranja.

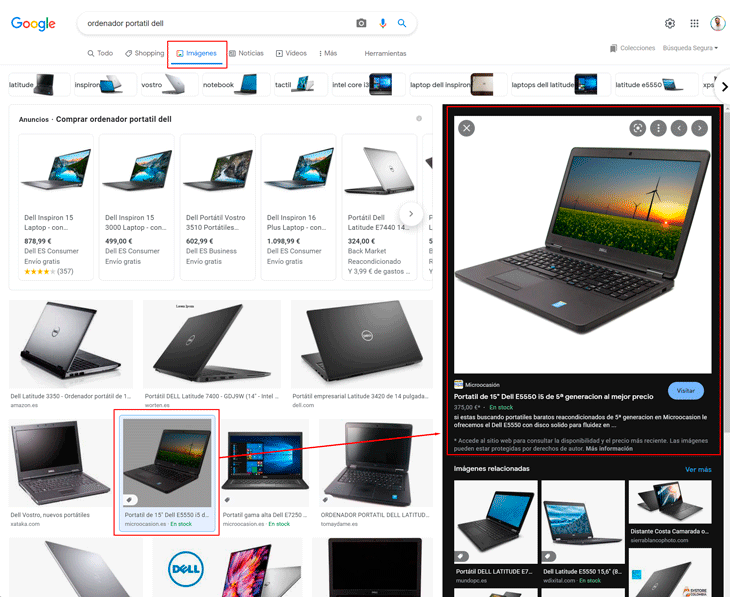

En los resultados de búsqueda de Google Imágenes

Al igual que en el caso anterior, si hacemos una búsqueda en la pestaña de Google Imágenes con intención de compra, además de los resultados de anuncios de Google Shopping, veremos resultados de productos enriquecidos.

Si hacemos clic en una ficha de producto orgánica, se nos despliega a la derecha toda la información del producto y podemos acceder directamente a la ficha de producto en el e-commerce en cuestión pinchando en la imagen, en el título, o en el botón «Visitar».

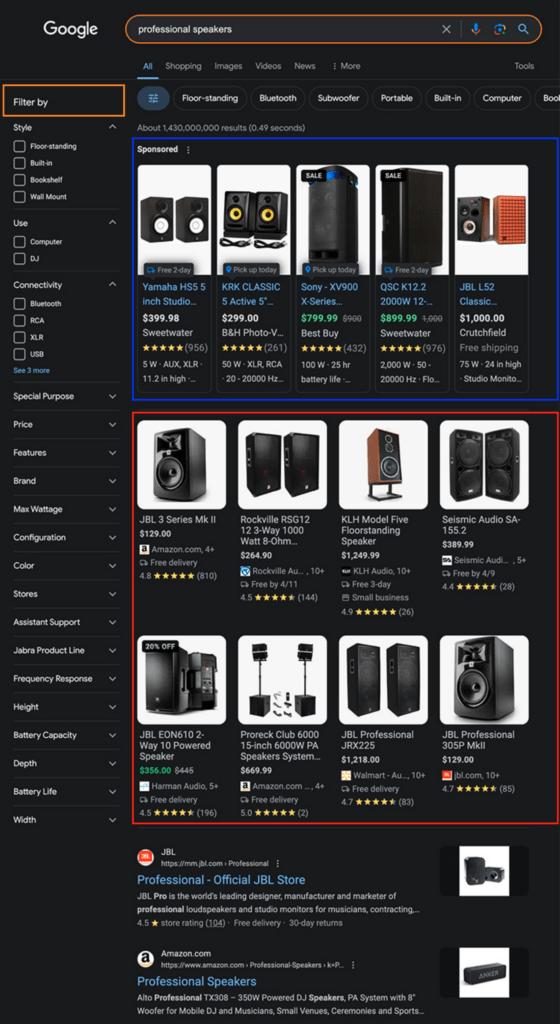

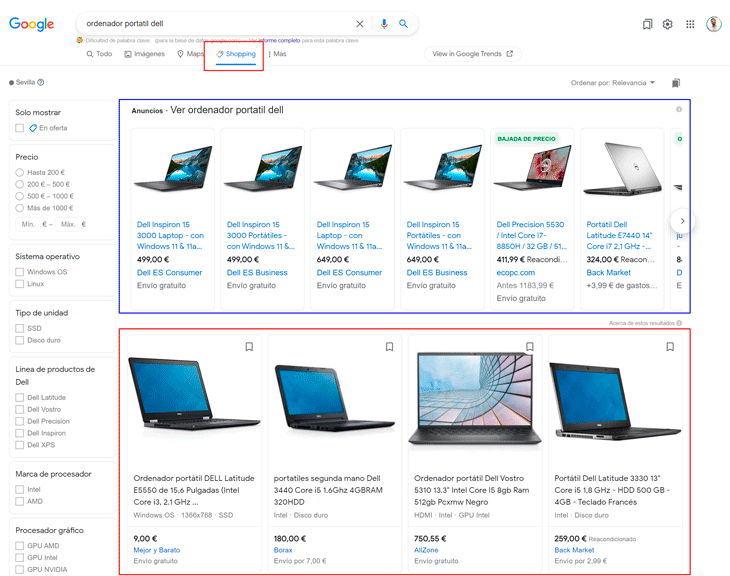

En los resultados de búsqueda de la pestaña de Google Shopping

Una de las grandes ventajas de las fichas gratuitas es que aumentamos la visibilidad en Google Shopping sin tener que pagar por ello.

Al hacer una búsqueda de producto en el buscador de Shopping, aparecerán resultados orgánicos bajo los anuncios de Shopping.

Si además de tener activas campañas de Google Shopping, tenemos configuradas las fichas gratuitas en panel de Google Merchant o en el nuevo panel de Google Merchant Next, aumentamos las posibilidades de conseguir clics en esta sección.

En la siguiente captura de pantalla se muestra una búsqueda dentro de Google Shopping. Los productos en el cuadrado azul provienen de campañas de Google Shopping y los del cuadrado rojo de las fichas gratuitas.

En Google Lens

Si un usuario busca un producto desde su dispositivo móvil con la aplicación de Google Lens, obtendrá resultados de fichas gratuitas con la posibilidad de ir directamente al sitio web y realizar su compra.

En la siguiente animación podemos ver cómo escaneando con Google Lens un producto, obtenemos un listado de resultados de imágenes:

- En el primer caso accedemos a una imagen de producto sin la posibilidad de compra en el sitio de destino.

- En el segundo caso, accedemos a un e-commerce donde podemos realizar directamente la compra del producto que estamos buscando. Antes de acceder, podemos observar que tiene la etiqueta de producto con el precio. Al hacer clic, nos muestra el resultado enriquecido con el título, las valoraciones, el precio, la disponibilidad, la marca y una descripción.

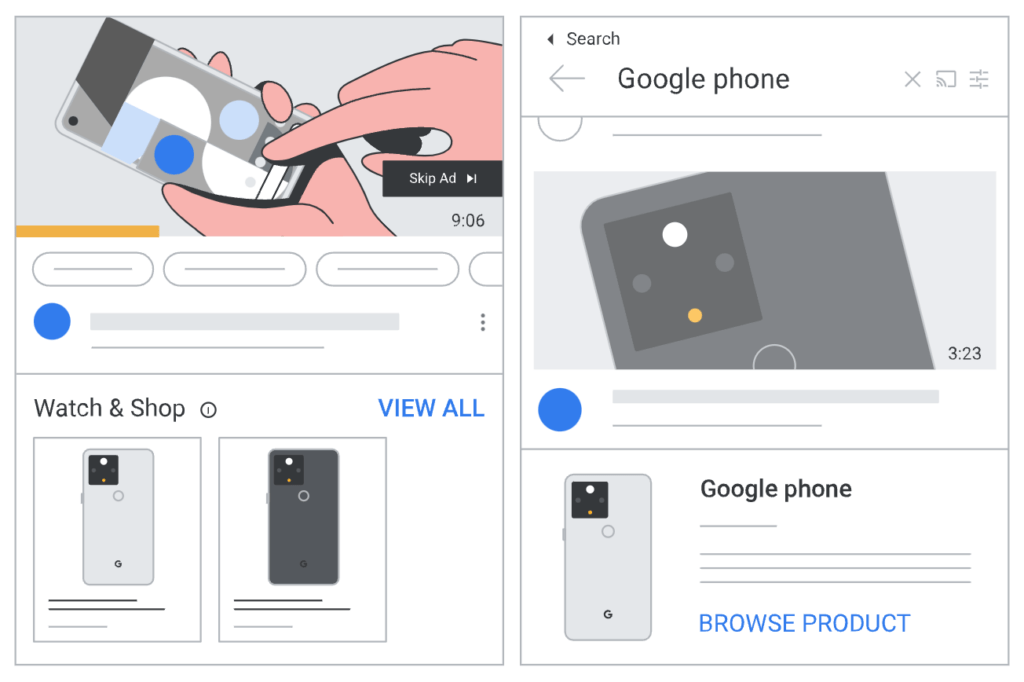

En YouTube

Si estás viendo un video en YouTube, se puede mostrar una lista de productos en contexto debajo del video con la posibilidad de comprar el producto directamente en el sitio web.

Además, si haces la búsqueda de un producto concreto en YouTube, existe la posibilidad de encontrar resultados de productos entre los resultados de video habituales.

Configuración de las fichas gratuitas

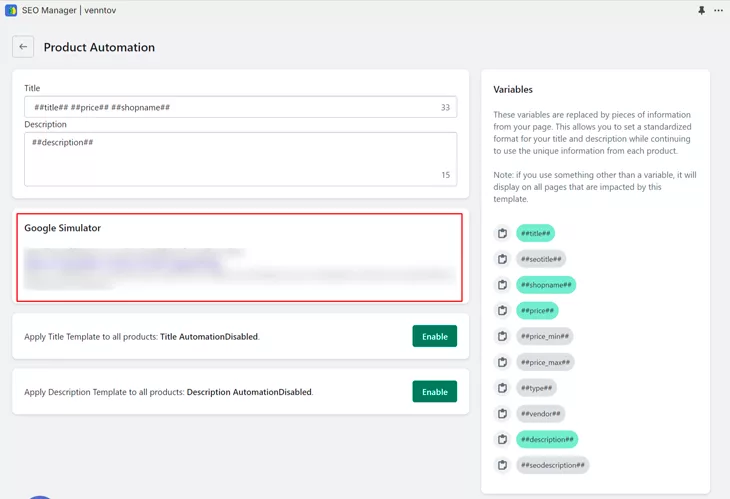

Para que las fichas gratuitas se muestren en las plataformas de Google, tenemos que activar las fichas gratuitas en Google Merchant e incluir datos estructurados de producto en el sitio web.

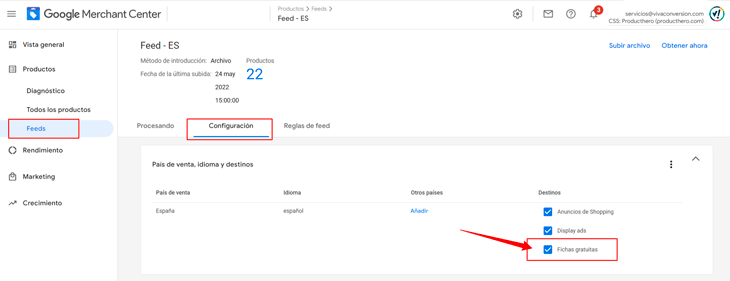

Configuración de las fichas gratuitas en Google Merchant

Si no tienes una cuenta de Merchant porque no has activado campañas de Google Shopping, primero tendrás que crear una cuenta.

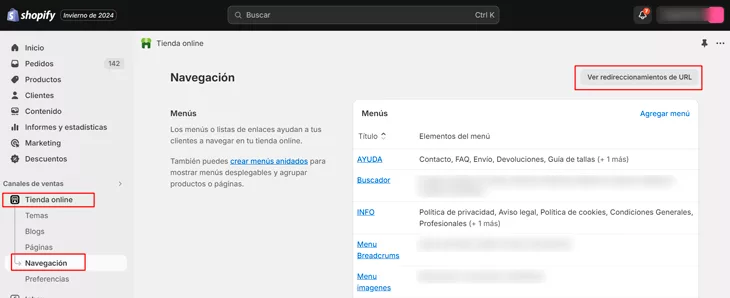

En cambio, si ya tienes creada una cuenta de Google Merchant para las campañas de Shopping con un feed de datos activo, solo tienes que activar las fichas gratuitas en el menú de la izquierda de la plataforma. En “Gestionar programas” -> “Fichas de productos gratuitas”, completamos la información de la empresa, aceptamos la “Política de reseñas” e incluimos el “Enlace a la política de envíos” que debe estar visible en el sitio web.

Además, debemos asegurarnos de marcar “Fichas gratuitas” en “Destinos” de la configuración del feed:

Cabe destacar, que aunque no tengas campañas de Google Shopping activas, tenemos la posibilidad de aparecer en la pestaña de Shopping con las fichas de producto gratuitas. Solo tenemos que incluir un feed de datos y activar las fichas gratuitas en la configuración.

Este proceso nos dará la oportunidad de conseguir visibilidad con las fichas de producto gratuitas en la pestaña de búsqueda de Google Shopping.

Incluir datos estructurados en el sitio web

Si tenemos añadidos los datos estructurados de productos en la tienda online, automáticamente se mostrarán las fichas de producto gratuitas en todas las superficies de Google, excepto en la pestaña de Google Shopping.

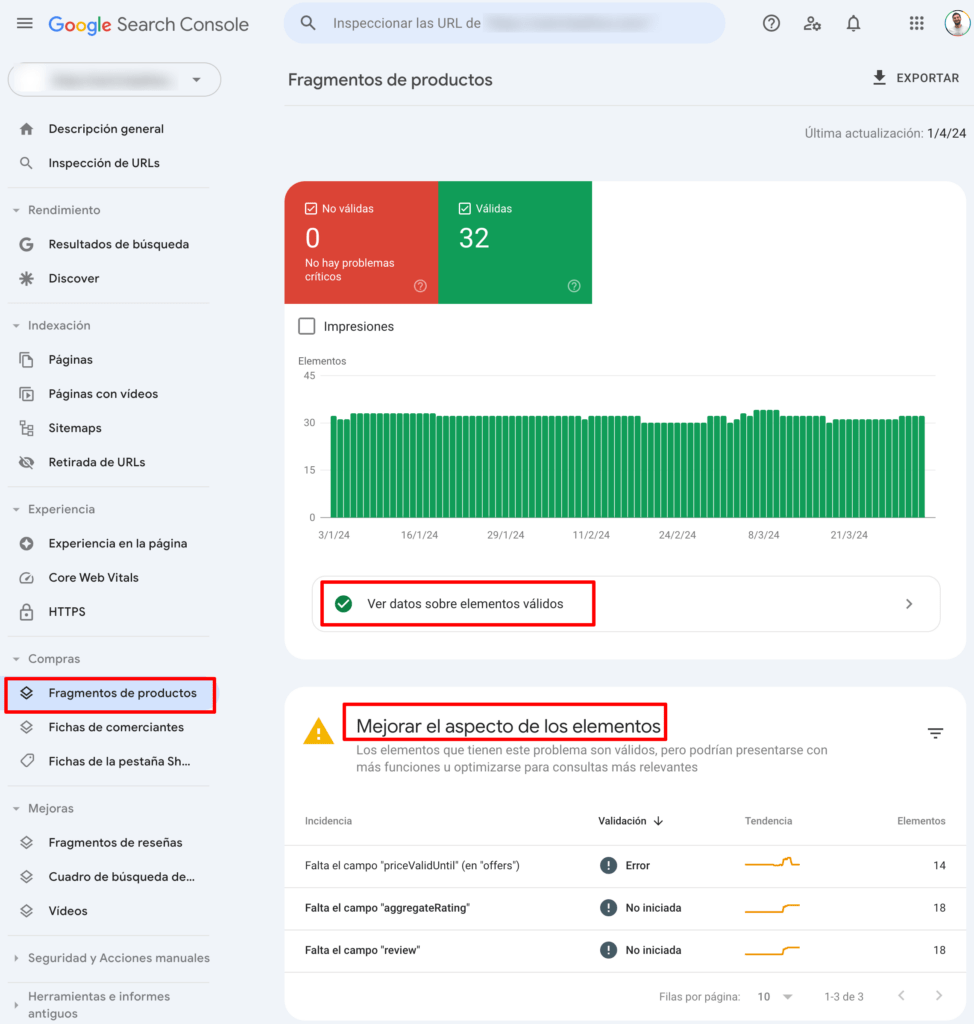

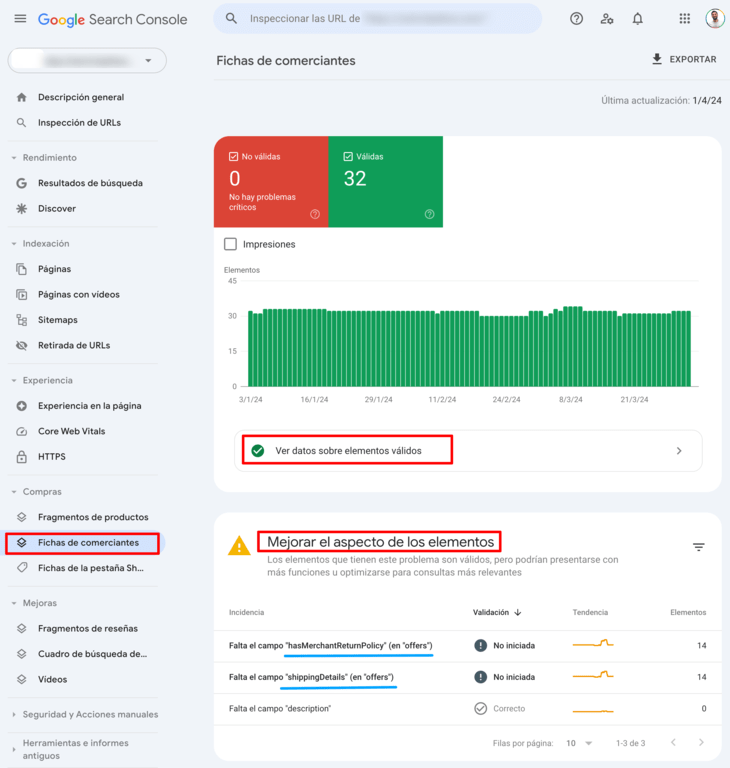

Actualmente, tenemos disponible en Search Console dos apartados relacionados con los datos estructurados de productos en la sección «Compras»: Fragmentos de productos y Fichas de comerciantes.

Fragmentos de productos

Estos datos estructurados llamados «Fragmentos de productos» habilitan la posibilidad de mostrar las fichas de productos enriquecidas que comentamos al principio y que pueden incluir imagen, precio, disponibilidad y valoraciones sobre el producto. Este tipo de datos estructurados está disponible tanto para páginas web que muestran información del producto, como para sitios que venden productos o publican reseñas de productos o muestran información de otros sitios.

Es importante revisar en Search Console los elementos válidos y aquellos que muestran errores y/o advertencias para maximizar la visibilidad que nos ofrece este tipo de resultados.

Fichas de comerciantes

El apartado de «Fichas de comerciantes» se habilitó en las cuentas de Search Console de los administradores de tiendas online en septiembre de 2022. Estos datos estructurados ofrecen a las tiendas online la posibilidad de aumentar la visibilidad de sus productos sin tener una cuenta de Google Merchant Center.

Con estos nuevos requerimientos de datos estructurados la información que facilitamos a Google es más específica y se iguala a la que enviamos a través del feed de datos de Merchant Center. Ahora debemos incluir datos relacionados con el envío, la política de devolución, las tallas, la eficiencia energética de los productos… siguiendo el estándar de etiquetado para productos de scehma.org.

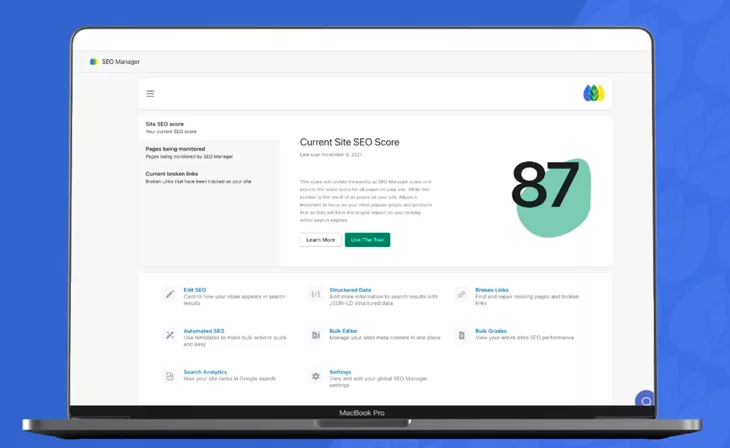

Analizar rendimiento de las fichas gratuitas de Google

Para analizar el rendimiento de los diferentes resultados de las fichas de gratuitas de Google, podemos consultar los datos en Search Console, en Merchant Center y en Google Analytics 4.

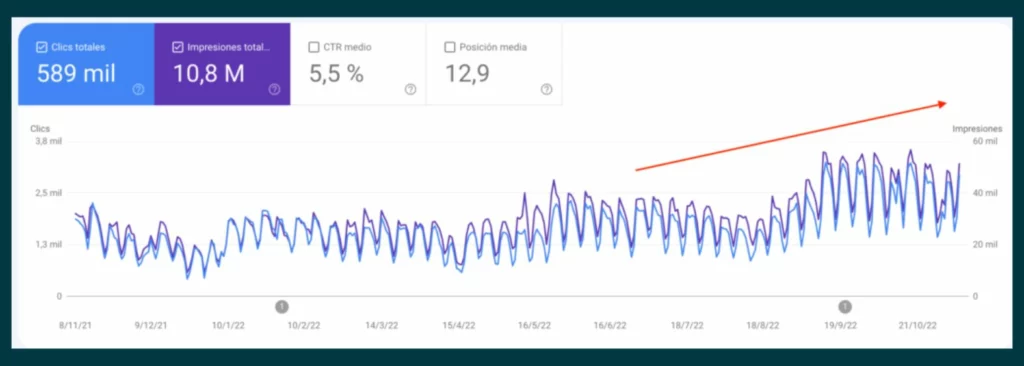

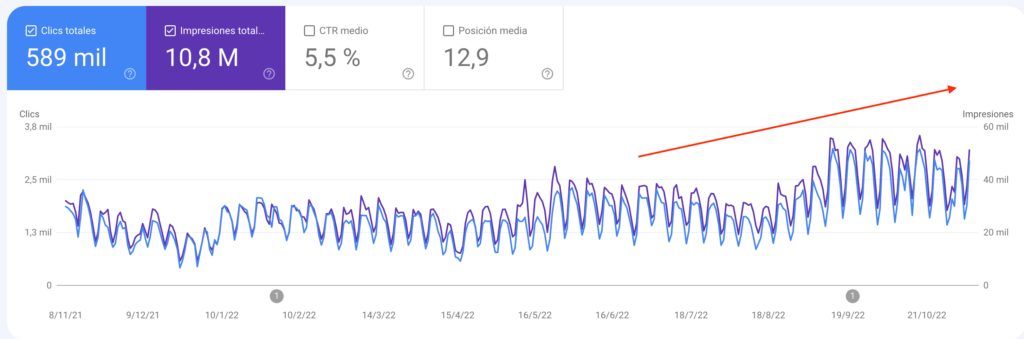

En Search Console

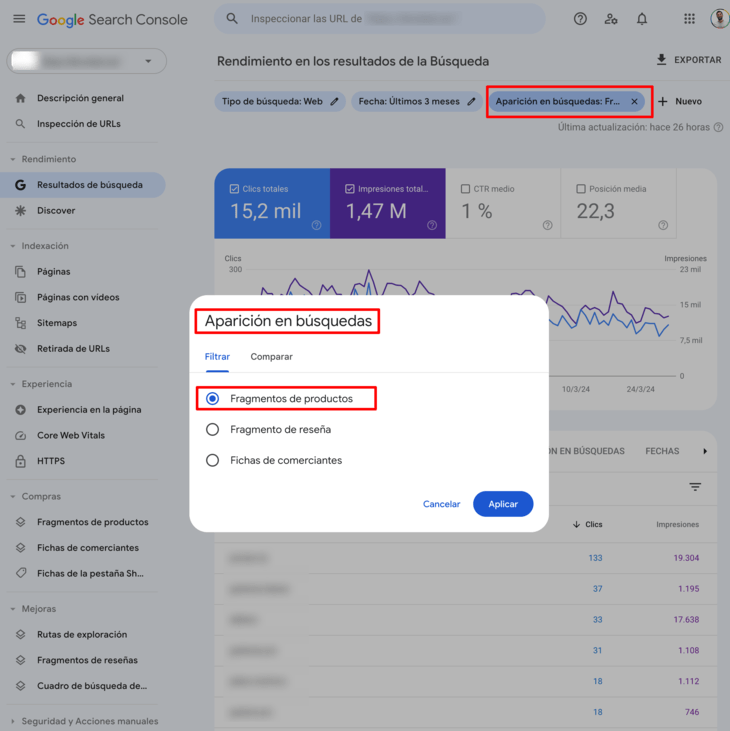

En el apartado de «Resultados de búsqueda» de Search Console, podemos medir el rendimiento específico de los «Fragmentos de productos» y de las «Fichas de Comerciantes».

Fragmentos de productos

Podemos consultar el rendimiento de los fragmentos de productos accendiendo al «Rendimiento» de los «Resultados de búsqueda» en Search Console y aplicando el filtro de «Aparición en búsquedas» —> «Fragmentos de productos».

Veremos las cuatro métricas básicas: Clics, Impresiones, CTR y Posición media (Search Console no nos proporciona datos de ventas).

Los datos gráficos y numéricos se ajustan al filtro seleccionado y podemos ver detalles de las consultas que se han realizado, de las páginas (URLs), de los países, de los dispositivos y de las fechas.

Fichas de comerciantes

Para consultar el rendimiento de los fichas de comerciantes en el mismo filtro de la captura anterior, seleccionamos «Fichas de comerciantes».

Al igual que en el caso anterior, podremos hacer seguimiento de las cuatro métricas básicas y ver los detalles de las consultas que han generado impresiones orgánicas para este tipo de resultados.

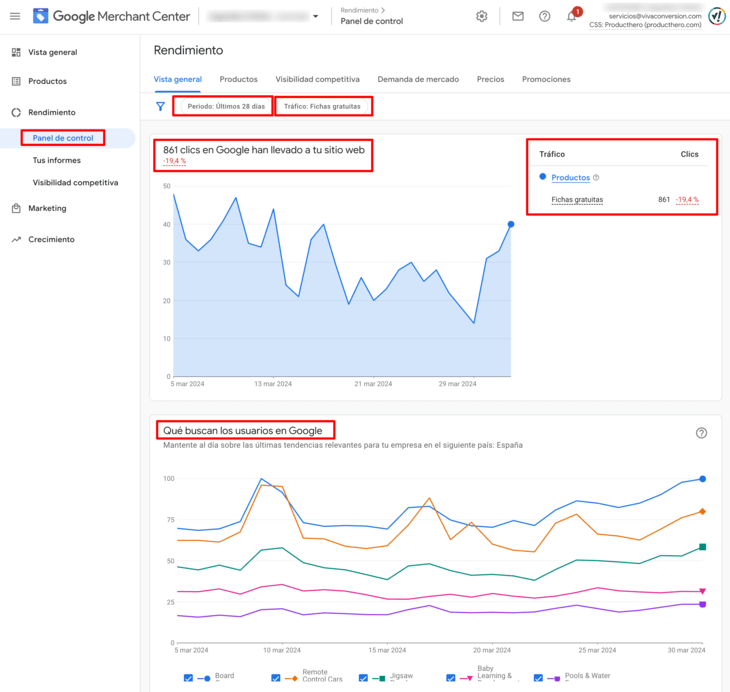

En Google Merchant Center

En la plataforma de Google Merchant Center, podemos consultar datos del rendimiento de las fichas gratuitas en la pestaña de Google Shopping accediendo a «Rendimiento» —> «Panel de control» —> «Vista general».

Una vez dentro de esta sección aplicamos el filtro «Tráfico» —> «Fichas gratuitas» y podemos ajustar el periodo que nos interese. La plataforma nos muestra el número de clics del periodo seleccionado y nos muestra la evolución en porcentaje con respecto al periodo anterior.

Además, en la gráfica inferior nos muestra información sobre las últimas tendencias de búsquedas de categorías de productos relacionadas con los productos que tenemos vinculados en el feed de datos.

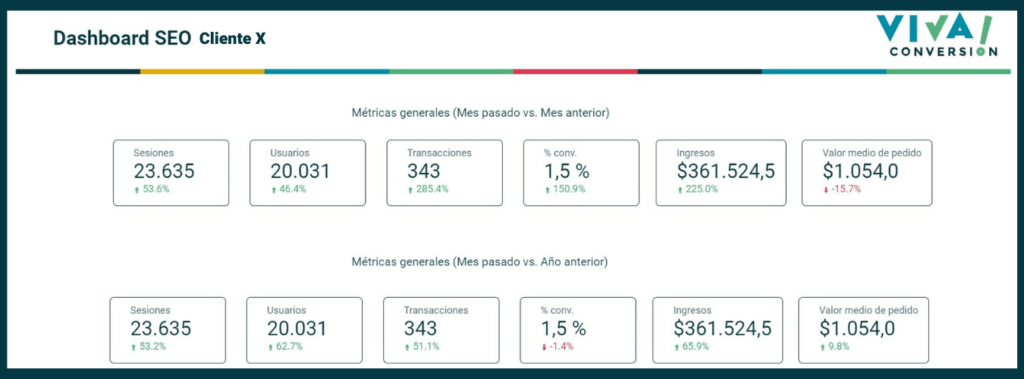

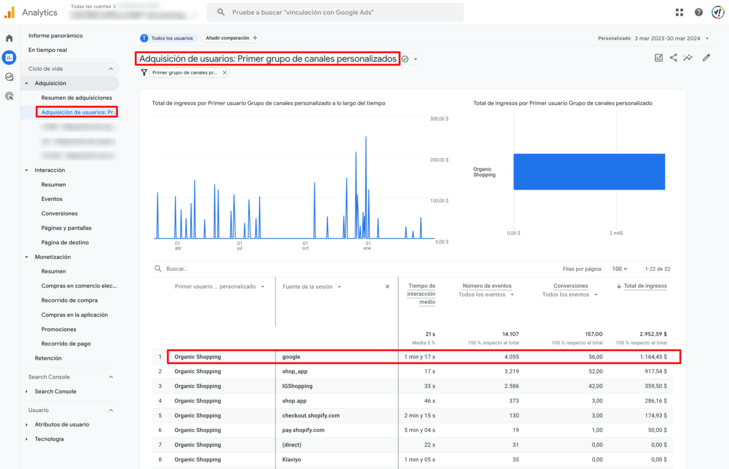

En Google Analytics 4

En Google Analytics 4, los datos de rendimiento de las fichas gratuitas se muestran en el informe de «Adquisición de usuarios», filtrando la agrupación de canales «Organic Shopping» y revisando los datos sociados a la fuente «Google». Aquí podremos consultar datos más completos del rendimiento, incluyendo los ingresos generados.

Características a destacar de las fichas gratuitas

- Para aparecer en las búsquedas de productos, Google clasifica los sitios web teniendo en cuenta la optimización orgánica (SEO). Al igual que clasifica el resto de resultados orgánicos en las SERP.

- Google puede rastrear todos los productos más populares de una tienda online y tiene la posibilidad de dar prioridad en las SERP a aquellos que tengan más opiniones y comentarios.

- Cuando se muestran los resultados de una búsqueda se pueden mostrar a los usuarios los productos de aquellas tiendas online que tienen mejores precios.

- Se muestran resultados enriquecidos de productos que incluyen: la imagen, el precio, las valoraciones, la marca, la disponibilidad, los gastos y el tiempo de envío, la categoría a la que pertenecen, la posibilidad de filtrar por estilos o tamaños… de aquí la importancia de que el sitio web tenga una buena estructura orientada a SEO y mantengamos los datos estructurados y el feed de datos todo lo completo posible.

- Mejora la experiencia de usuario (UX) y potencia las ventas de productos.

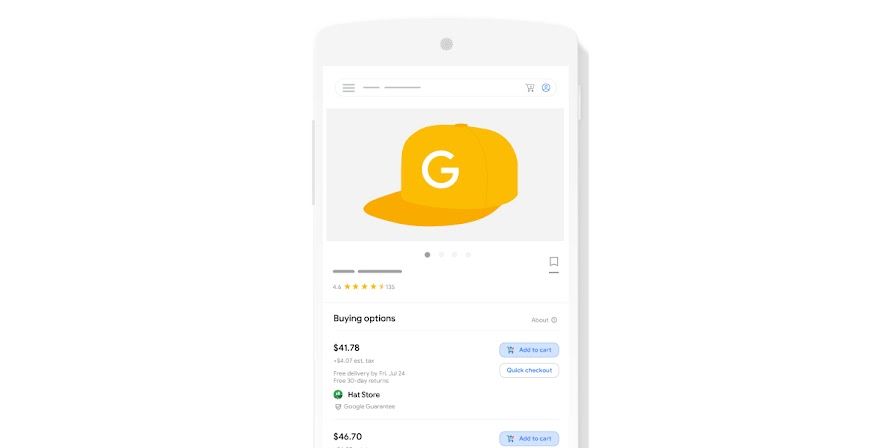

- Además, próximamente estará disponible en España “Buy on Google” que dará la posibilidad de comprar productos de una tienda online sin salir del buscador. El resultado enriquecido mostrará un botón para añadir al carrito el producto y completar la compra.

Conclusiones

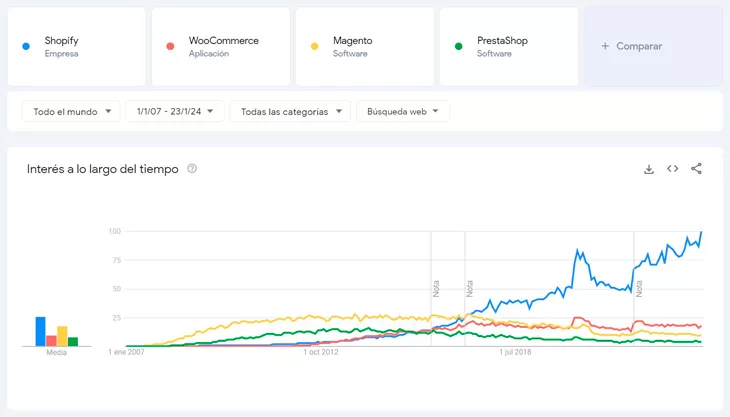

Las diferentes plataformas de Google están en continua evolución, mostrando cada vez más tipos de resultados enriquecidos. Y los sitios webs deben ir implementado mejoras continuamente para adaptarse al cambio y diferenciarse frente a la competencia que cada vez es mayor.

Si necesitas asesoramiento, en VIVA! Conversion estamos para ayudarte a potenciar las ventas de tu tienda online. ¡No dudes en contactar con nosotros!

Tabla de contenidos

Toggle