Experimentación en negocios digitales: Qué hacer cuando existe poco tráfico

Javier Brizuela

La experimentación es un de las herramientas clave para tomar decisiones basadas en datos. A través de ella, podemos optimizar procesos, mejorar la experiencia del usuario y, en última instancia, incrementar la tasa de conversión. Sin embargo, cuando se trata de negocios digitales con poco tráfico, este enfoque puede volverse complicado. Esto se debe a que el tráfico limitado presenta desafíos adicionales que requieren adaptaciones en las estrategias de testeo y en la interpretación de los resultados.

En este artículo, te contamos cómo las empresas con poco tráfico pueden aplicar otros métodos de validación a la hora de experimentar, más allá de las pruebas A/B tradicionales.

El reto del tráfico limitado

Cuando hablamos de poco tráfico, no solo nos referimos a que la cantidad total de usuarios que visitan un sitio web sea baja. Este problema se agrava a medida que los usuarios avanzan a través del funnel de conversión, con cada paso (como el inicio de checkout, o la conversión a compra) siendo completado por un número aún menor de personas.

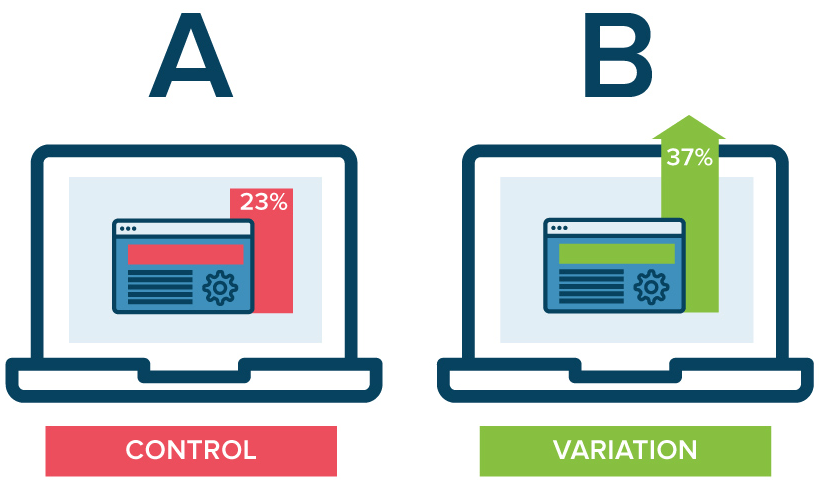

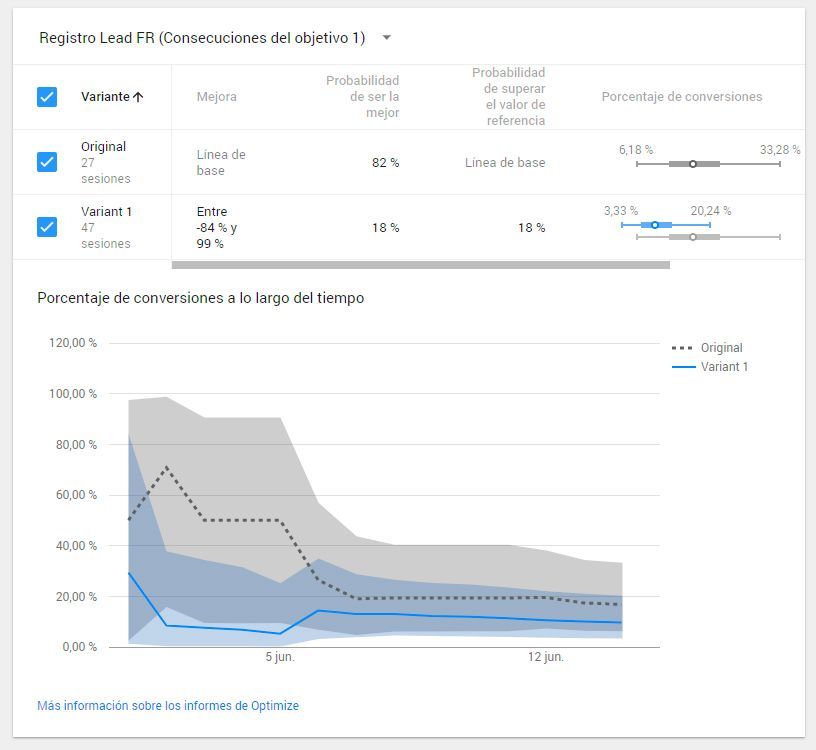

Esto hace que la experimentación A/B estándar, que requiere una muestra de usuarios con cierto volumen para obtener resultados fiables, sea difícil de implementar. Por ello, es necesario considerar enfoques alternativos que se adapten mejor a estas limitaciones.

Pensar más allá de las pruebas A/B tradicionales

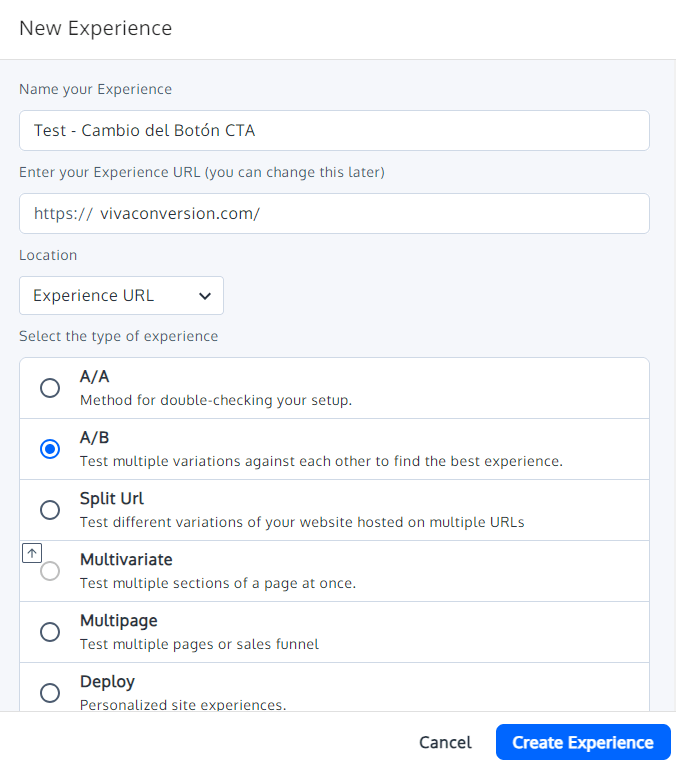

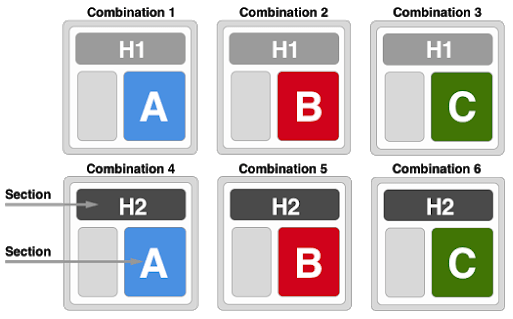

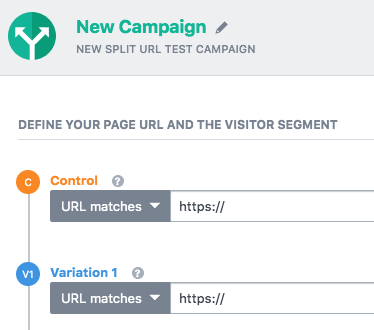

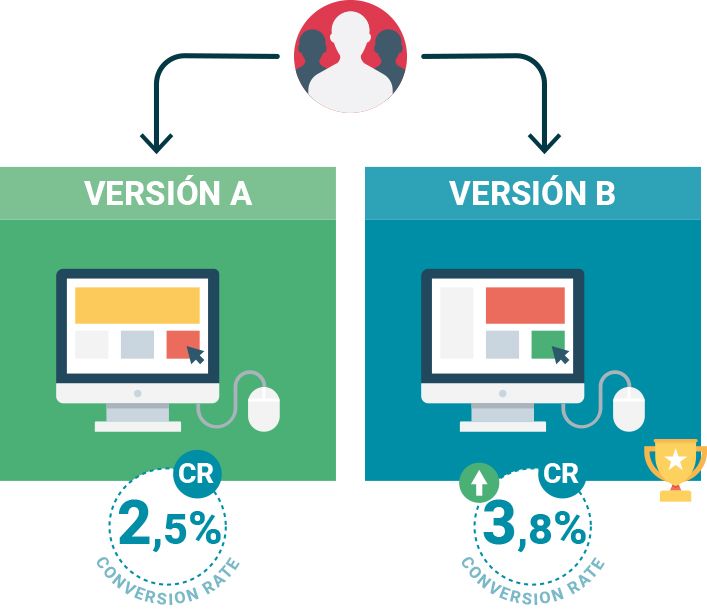

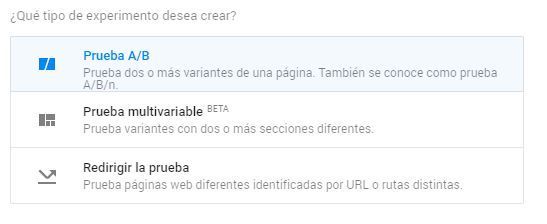

Las pruebas A/B son una metodología clásica en la experimentación digital y pueden no ser suficientes o tan efectivos en el caso de negocios con poco tráfico.

Al trabajar con muestras pequeñas, es crucial explorar otros métodos de validación de hipótesis, más allá del enfoque típico de pequeñas variaciones entre versiones. En muchos casos, probar cambios más grandes y arriesgados o validar mediante test de usuarios, entre otras muchas opciones, puede ofrecer resultados más claros y tangibles.

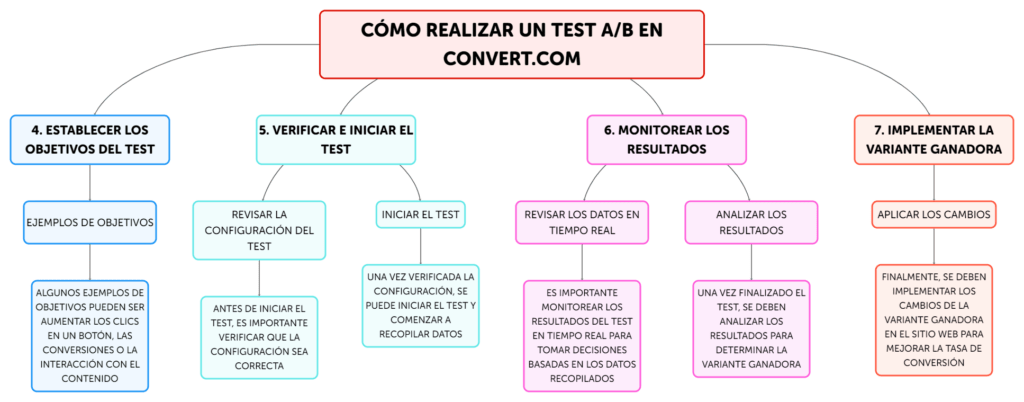

Conceptos clave para un programa de experimentación

Antes de llevar a cabo un programa de experimentación efectivo, es necesario comprender una serie de conceptos clave de la experimentación, además de entender cómo la cantidad de tráfico de nuestro negocio puede condicionar la fiabilidad y validación de nuestro programa de experimentación.

MDE (Efecto Mínimo Detectable)

El MDE es la diferencia mínima entre dos versiones de un test (A y B) que puede ser detectada de manera fiable. Se trata de un pilar muy importante la experimentación de negocios digitales con poco tráfico.

En un negocio con alto tráfico, es posible detectar diferencias pequeñas entre las variantes, como cambiar el color o la posición de un botón. Sin embargo, en un negocio con poco tráfico, hay que tener en cuenta que los pequeños cambios pueden llegar a ser insuficientes o llevar mucho tiempo hasta conseguir resultados fiables.

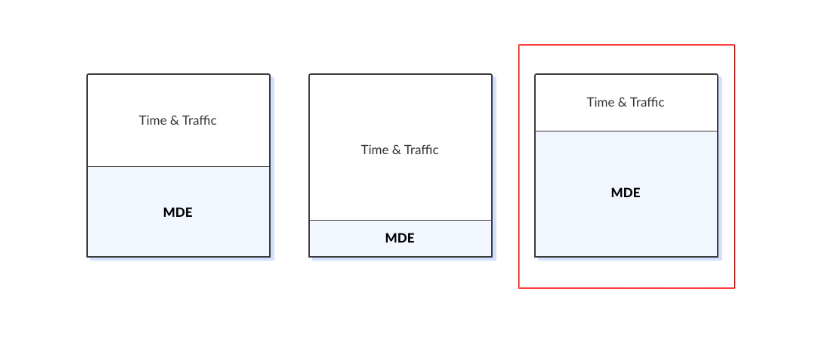

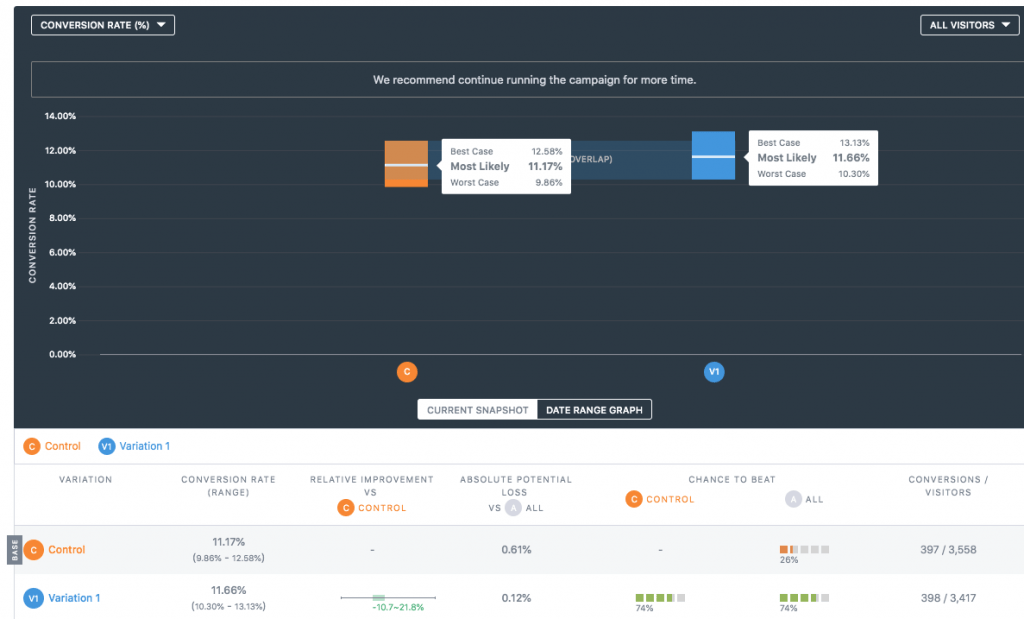

Un MDE bajo aporta resultados mínimamente fiables cuando existe mucho tráfico y tiempo (imagen central). En cambio, cuando el tiempo y el tráfico son escasos, se necesitará de un MDE muy alto para conseguir resultados fiables.

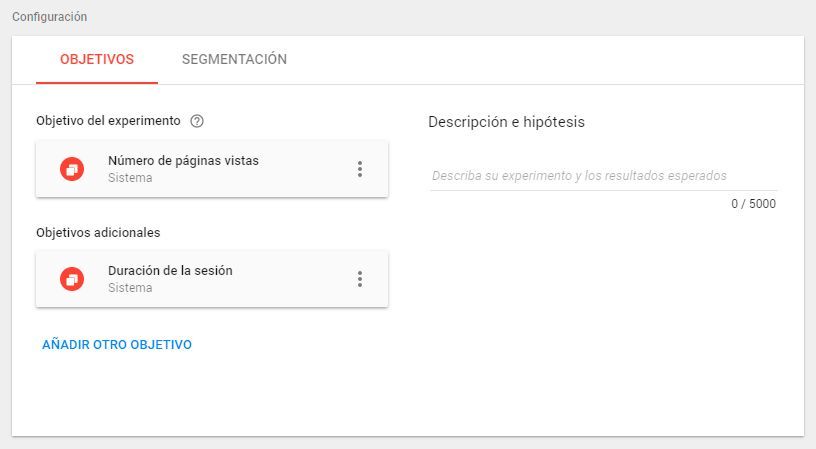

Nivel de confianza

En la mayoría de los tests, se utiliza un nivel de confianza del 95%, lo que significa que existe un 95% de probabilidad de que los resultados no sean fruto del azar.

El poder estadístico es la capacidad de un test para detectar un efecto real si este existe. Generalmente, se utiliza un poder estadístico del 80%. En entornos de bajo tráfico, es posible que tengamos que reducir este valor para obtener resultados, pero esto también implica aceptar un mayor riesgo de falsos negativos.

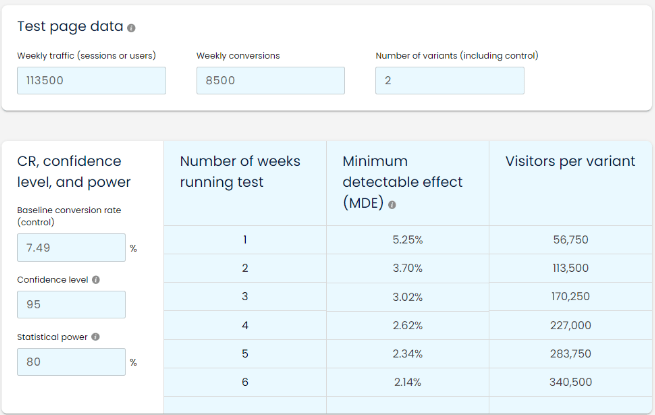

Puedes usar la calculadora de Speero by CXL para hacer los cálculo en base a los estándares de la industria.

Duración de los tests

Aunque la tentación puede ser extender un test por un largo período para obtener más datos, esto puede generar problemas. Factores externos, como promociones de la competencia o caídas puntuales en la web, pueden alterar los resultados si el test se alarga demasiado.

En general, se recomienda limitar la duración de los tests a unas 2 o 3 semanas para minimizar la interferencia de factores externos.

Ajustes estratégicos en la experimentación

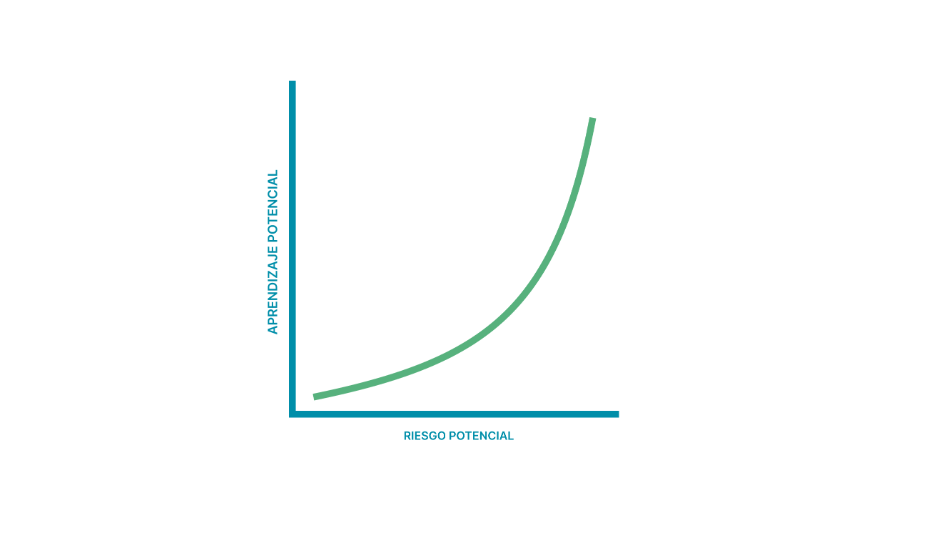

La clave de la experimentación A/B reside en el riesgo potencial que estamos dispuesto a asumir (aplicando cambios más drásticos, inversión en investigación, rigor estadístico, etc.) frente al aprendizaje potencial que queramos obtener. En el caso de tener un tráfico limitado, el riesgo potencial aumenta, en la medida en que deseemos mantener el mismo volumen de aprendizaje.

Aumentar el MDE

Dado que es difícil detectar pequeños cambios con poco tráfico, es esencial apuntar a cambios más drásticos. Por ejemplo, en lugar de cambiar detalles menores como el tamaño de un botón, se podrían probar variaciones de diseño más extremas, como rediseñar por completo dicho botón, o modificaciones en el funcionamiento del mismo, que generen una reacción más polarizada de los usuarios. Ten en cuenta que, cuanto mayor sea el cambio, más significativo será el efecto detectable, lo que permitirá obtener resultados más claros.

Pero, ¿cómo podemos aumentar el MDE en nuestro programa de experimentación?

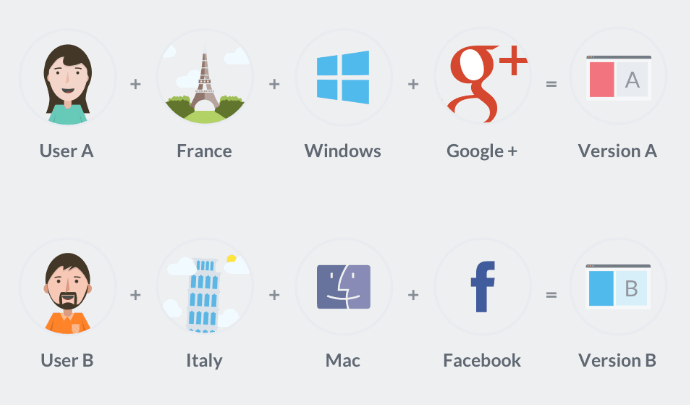

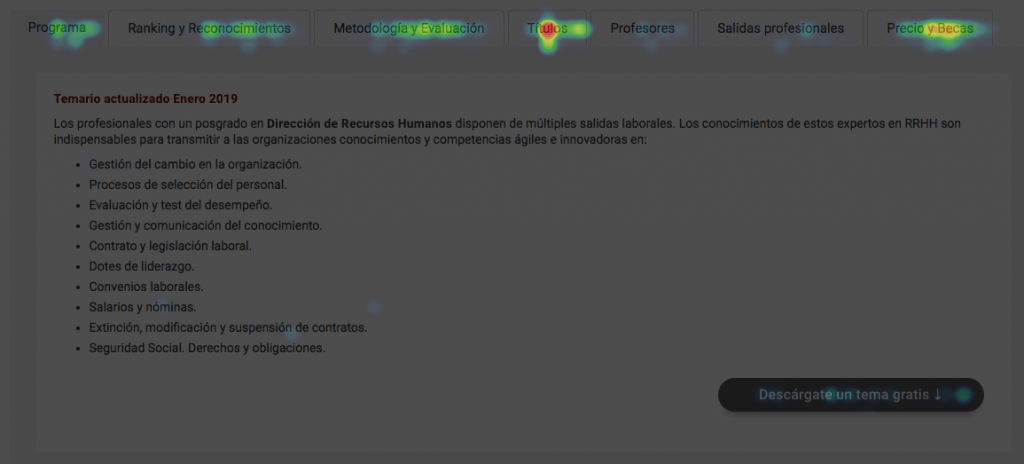

Conocer mejor al usuario

El análisis cualitativo, como entrevistas o análisis de grabaciones de sesiones, puede ser clave para entender qué cambios tienen más probabilidades de impactar de forma significativa. Cuanto más entendamos sobre las necesidades y fricciones del usuario, mejor podremos diseñar tests que produzcan resultados claros.

Ajustar el rigor estadístico

Reducir el nivel de confianza y el poder estadístico puede ayudar a obtener resultados en menos tiempo, aunque a costa de reducir la certeza de los mismos. Cada empresa debe decidir cuánto riesgo está dispuesta a asumir en función de sus objetivos y capacidad de aprendizaje.

Asumir mayores riesgos en los cambios

En algunos casos, puede ser necesario arriesgarse con cambios más radicales. Probar cambios visuales o estructurales que alteren significativamente la experiencia del usuario puede generar respuestas más polarizadas, pero también más medibles.

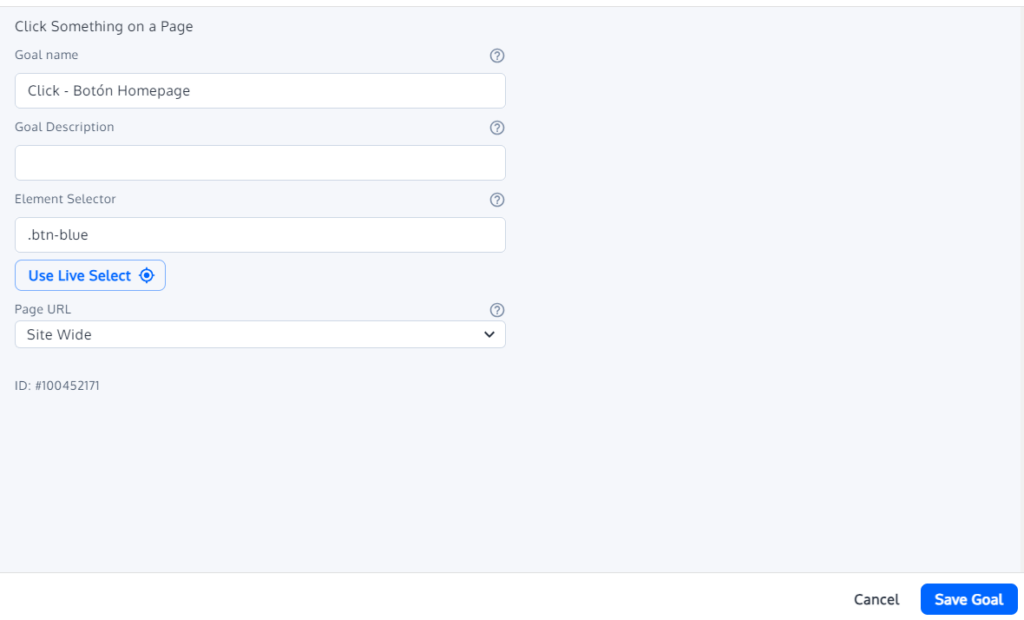

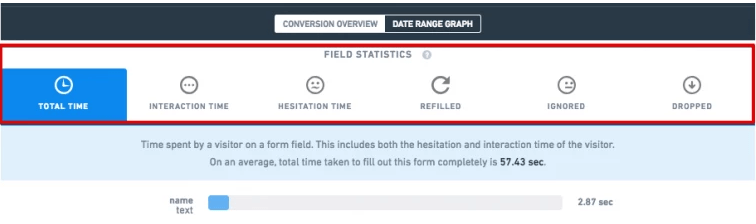

Microconversiones y KPIs secundarios

Si medir la conversión final (como una compra) resulta imposible por la falta de tráfico, se puede optar por medir microconversiones o KPIs secundarios.

No debemos limitarnos a medir únicamente las conversiones. También se pueden medir otro Estos podrían incluir el número de usuarios que añaden un producto al carrito, inician el proceso de pago o interactúan con un elemento clave de la página. Estas métricas intermedias proporcionan una idea de cómo los usuarios están respondiendo a los cambios y permiten ir obteniendo aprendizajes a lo largo del funnel.

Aumentar la duración de los test

Por último, aunque hemos comentado anteriormente que no se recomienda extender los test más allá de las 2 o 3 semanas, debido al posible incremento de factores externos que afecten a nuestros datos, es importante entender que cuando más tiempo dejemos el test correr, menor será el MDE que podremos detectar. Esta última solución no nos ayuda a aumentar el MDE, pero entender como se relacionan la duración de los test y el MDE nos ayudará a tomar mejores decisiones sobre cuánto tiempo estamos dispuestos a dejar correr nuestro test.

Conclusiones

A pesar de los desafíos, es posible realizar experimentación en negocios con poco tráfico siempre y cuando se adopten estrategias adecuadas. La clave está en adaptar el enfoque tradicional de la experimentación a las limitaciones del tráfico y estar dispuesto a asumir ciertos riesgos, así como utilizar diferentes métodos de validación de hipótesis, más allá de la experimentación a/b. Con un enfoque en el aprendizaje continuo, el análisis cualitativo y la toma de decisiones basada en datos sólidos, incluso los negocios más pequeños pueden beneficiarse de la experimentación para mejorar su rendimiento y optimizar su funnel de conversión.

Recuerda, en un entorno donde cada visita cuenta, adoptar una mentalidad experimental flexible y basada en el análisis profundo puede marcar la diferencia entre el estancamiento y el crecimiento. En viva! estamos preparados para ayudarte a diseñar y ejecutar estrategias de experimentación personalizadas que maximicen el rendimiento de tu negocio digital, incluso con poco tráfico.